Inventory Management with Attention-Based Meta Actions

泉谷 圭亮,シモセラ エドガー

ローグライクゲームは強化学習アルゴリズムにとって非常に挑戦的な環境である.というのも,ゲームに敗北する度に最初からやり直さなければならず,環境は確率的かつ手続き的に生成され,そして適切にゲーム内のアイテムを使用することがゲーム攻略には不可欠であるためである.最近の研究では,ローグライクを基にした強化学習アルゴリズムのための環境や,挑戦的なローグライクに取り組むモデルが提案されているが,我々の調査する限り,アイテムの扱いを対象としたものはない.アイテムはゲーム中に得られるもので,ローグライクにおいて重要な役割を果たしている.しかし,アイテムは数が可変の非順序集合であり,さらにそれらが行動空間の一部を構成しているため,強化学習フレームワークにアイテムを組み込むのは簡単ではない.本研究では,非順序集合が行動空間の一部となっているこの問題に取り組み,アイテムを用いた行動も扱えるattentionベースの機構と,複雑な行動やアイテムを扱えるメタ行動フレームワークとを提案する.これらを挑戦的なゲームであるNetHackで評価した結果,提案手法は既存手法を大幅に上回る性能を示した.

口頭発表

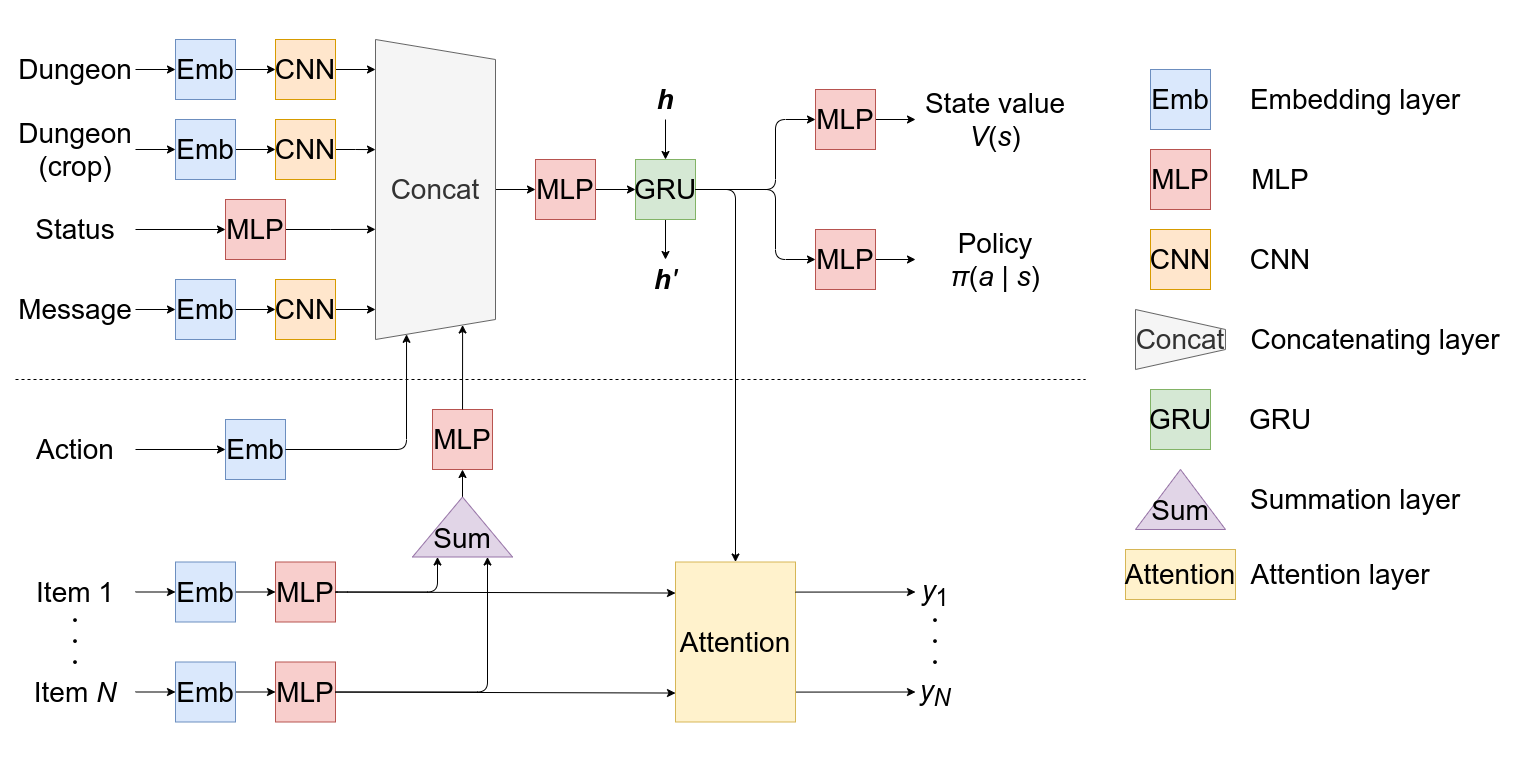

モデル

既存のモデル(破線の上側)に対して,行動再帰とアイテム特徴抽出とを組み込んでいる.

行動再帰

直前に取った行動を現在の状態の表現に組み込むため,埋め込み層をモデルに追加する.

インベントリの特徴抽出

所持している各アイテムの特徴 を計算した後,全アイテムの特徴 を, 順序に依らない演算 により計算する.

アイテムのスコア計算

行動決定時に用いる各アイテムのスコアをattention機構を用いて計算する. 具体的には,行列 とベクトル を用いて, 番目のアイテムのスコア を

によって計算する.ここで,

であり, は や の次元, は現在の状態の表現(GRUの出力)である.

正誤表

| ページ | 場所 | 誤 | 正 |

|---|---|---|---|

| 5 | 式(9) 2行目 |